El término tasa de rastreo (Crawl Rate) hace referencia al número de solicitudes por segundo que  el bot de Google (más conocido como GoogleBot) y de otros buscadores realizan en nuestro sitio web cuando se está rastreando. La tasa de rastreo es un aspecto muy importante del SEO que, no obstante, muchos administradores de sitios e incluso profesionales del sector pasan por alto. Si los bots de Google no pueden rastrear nuestro sitio efectivamente, muchas páginas de nuestro sitio no se indexarán.

el bot de Google (más conocido como GoogleBot) y de otros buscadores realizan en nuestro sitio web cuando se está rastreando. La tasa de rastreo es un aspecto muy importante del SEO que, no obstante, muchos administradores de sitios e incluso profesionales del sector pasan por alto. Si los bots de Google no pueden rastrear nuestro sitio efectivamente, muchas páginas de nuestro sitio no se indexarán.

Hoy por hoy, Google cuenta con sofisticados algoritmos que determinan la velocidad de rastreo óptima para un sitio, y su objetivo es rastrear tantas páginas de su sitio como pueda en cada visita sin sobrecargar el ancho de banda del servidor.

Los sitios optimizados con una buena arquitectura web (navegación usable, enlazado interno optimizado, etc…) facilitarán a los spiders y bots el rastreo e indexación del sitio. Para los sitios que se actualizan frecuentemente (por ejemplo, los periódicos y revistas digitales), es crucial que los bots puedan indexar el sitio en minutos tras publicar un nuevo artículo. Una vez que Googlebot haya rastreado nuestra página, seguirá los enlaces que en ella encuentre.

No está en nuestra mano controlar directamente la frecuencia con la que Google rastrea nuestro sitio, pero sí existen diversas acciones que podemos llevar acabo para aumentar el crawl rate y la velocidad de indexación:

Tabla de contenidos

Actualiza tu sitio con frecuencia

El contenido es lo más importante para los buscadores. Es su «alimento» diario, por lo que actualizar el sitio web lo más posible nos garantizará visitas más frecuentes de Googleblot. Los sitios estáticos lo tienen más complicado que los dinámicos, pero siempre se puede añadir nuevas páginas al sitio. Si aún no tienes un blog, comienza uno que proporcione al menos tres actualizaciones semanales. No todo tiene que ser texto, también puedes actualizar con vídeos, imágenes y audios.

Crea y envia sitemaps

La creación y el envío de sitemaps es una de las primeras cosas que debes hacer para que tu sitio sea indexado correctamente en su totalidad o, en el caso de que sea de reciente creación, descubierto por los bots. Una vez lo tengas puedes facilitar las cosas a los buscadores enviándolos a Search Console y a las herramientas para webmasters de Bing. Los principales gestores de contenido cuentan con plugins y extensiones para generar sitemaps dinámicos, como el Google XML sitemap para WordPress.

Evita el contenido duplicado

El contenido duplicado es enemigo de la tasa de rastreo, y ten por seguro que los buscadores detectan cada vez más fácilmente en contenido duplicado. Pero ojo porque el contenido duplicado se puede dar entre sitios web distintos y también dentro de páginas del mismo sitio. Con contenido duplicado no solo bajará tu crawl rate sino que serás penalizado y bajarás en el ranking.

Reduce el tiempo de carga de tu sitio

El crawl de Google no tiene un presupuesto ilimitado, por lo que asigna unos recursos limitados a cada sitio que visita. Cada sitio web tiene asignado un crawl budget, que es directamente proporcional a la autoridad de la página: a mayor autoridad de la web, más presupuesto te asignará Google y más tiempo pasará el bot en tu sitio. Por tanto, la mejor estrategia será reducir al máximo el tiempo de carga de nuestro sitio para que el bot no pase de largo y se «canse» de esperar. A menor tiempo de descarga de la página, mayor frecuencia de rastreo. Ten en cuenta que Googlebot no rastrea JavaScript, marcos, DHTML, Flash y contenido de Ajax, tan bien cómo el simple código HTML.

Bloquea los archivos inservibles mediante el archivo Robots.txt

Podemos allanarles el camino a los bots comunicándoles que no indexen páginas inservibles para el usuario como las páginas de aministración de los CMS, los archivos de plugins, etc… Mediante el comando «disallow» bloquearemos el acceso a esas rutas y directorios que no son necesario rastrear, permitiendo así que el bot pase más tiempo en las zonas útiles de nuestra web: la del contenido.

Utiliza los servicios de actualización de WordPress

Los servicios de actualización o Pinging de WordPress son una buena forma de informar de la existencia de nuestro sitio y sus actualizaciones. Existen servicios manuales como Pingomatic o FeedShark, pero WordPress permite (en el apartado ‘escritura’ de los servicios generales) añadir más servicios de ping que avisará a dichos servicios cada vez que publiquemos una nueva entrada de WordPress. Aquí tienes una lista completa de dichos servicios.

Optmiza el enlazado interno

En enlazado interno de una web es, básicamente, un camino de migas de pan que el Googlebot puede seguir fácilmente para rastrear nuestro sitio. Puedes analizar tu estructura interna de enlaces y sus posibles errores en Google Search Console (en el apartado tráfico de búsqueda > enlaces internos). En la parte superior verás las páginas con más enlaces internos. Dichas páginas deberían ser las más importantes de tu sitio.

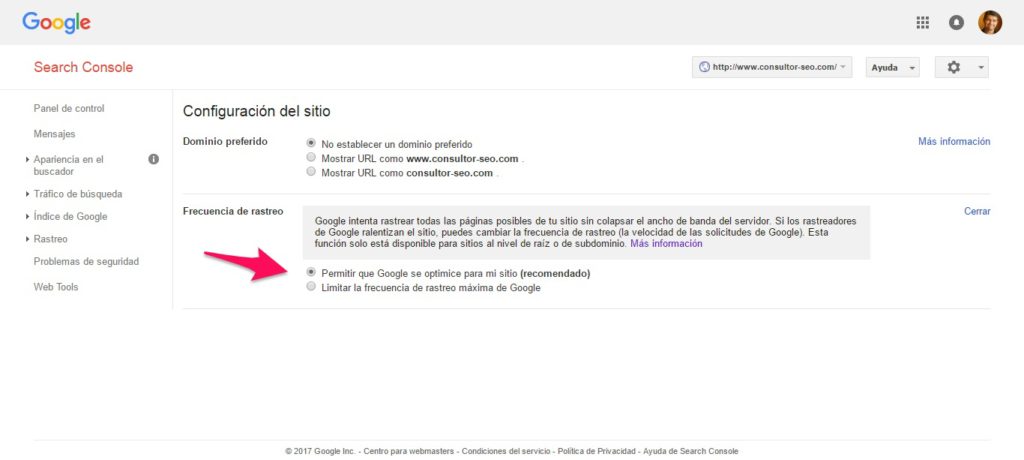

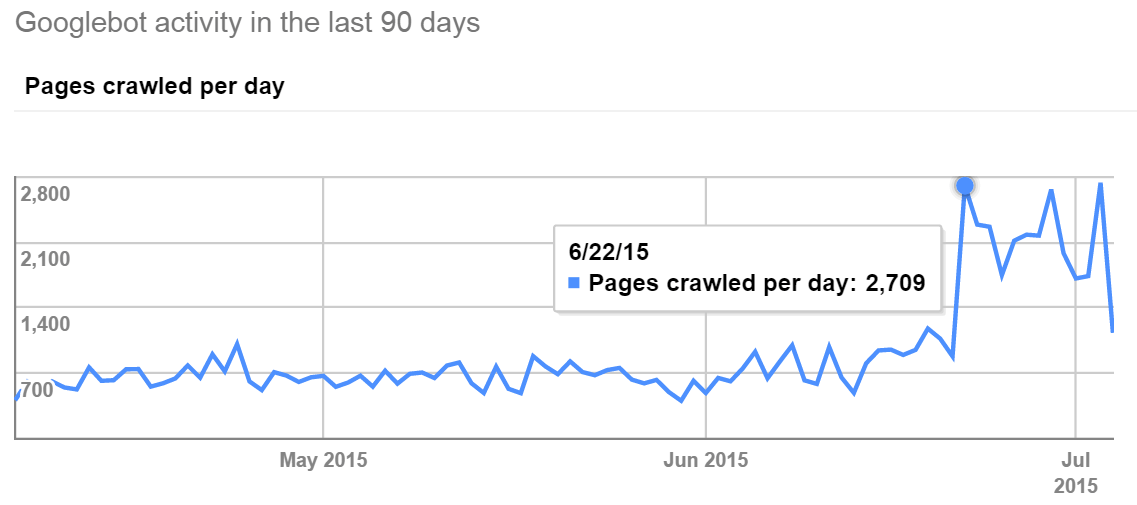

Comprueba el Crawl Rate de Google

En las opciones de configuración de nuestro sitio en Search Console es posible monitorizar las estadísticas de rastreo de Google, y también, si así lo deseamos, disminuir la tasa de rastreo; pero a no ser que tengas problemas de caída o ralentización del tu servidor porque el Googlebot esté haciendo demasiadas peticiones por segundo, no es recomendable limitar el crawl rate. Simplemente, comprueba que la frecuencia de rastreo esté marca en la opción recomendada por defecto. Esta función solo está disponible para sitios al nivel de raíz o de subdominio.

Todos estos cambios te ayudarán a aumentar la tasa de rastreo del sitio y a obtener una mejor indexación en Google y otros motores de búsqueda.